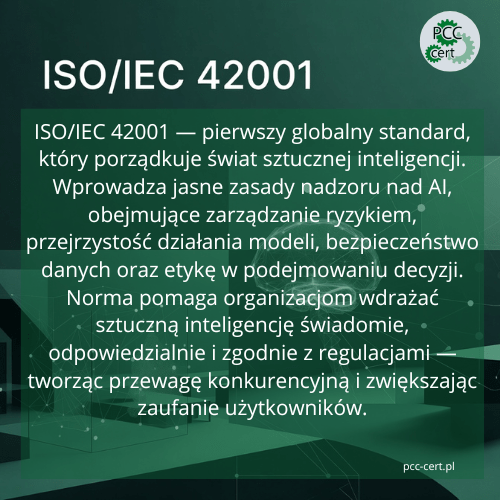

ISO/IEC 42001 to pierwszy międzynarodowy standard zarządzania sztuczną inteligencją (AI),

który pomaga organizacjom wdrażać i nadzorować systemy AI w sposób świadomy, odpowiedzialny

i bezpieczny.

narzędzia, które zaczyna wpływać na działanie całych organizacji. Automatyzuje procesy,

analizuje ogromne zbiory danych, rekomenduje decyzje, a czasem nawet decyduje za ludzi.

Wraz z tym wzrostem znaczenia pojawiło się jednak pytanie, które wcześniej rzadko zadawano:

kto i w jaki sposób nadzoruje działanie AI?Właśnie w odpowiedzi na to powstała norma

ISO/IEC 42001, opisana szczegółowo na stronie

Międzynarodowej Organizacji Normalizacyjnej ISO

.

Jest to pierwszy międzynarodowy standard, który tworzy ramy dla

zarządzania sztuczną inteligencją — tak, aby była ona wdrażana świadomie,

odpowiedzialnie i bezpiecznie.

Spis treści

Dlaczego powstało ISO/IEC 42001?

Z perspektywy biznesu i administracji coraz częściej mówiło się o potrzebie uporządkowania

zagadnień związanych z AI. Modele potrafiły podejmować decyzje szybciej niż człowiek, ale

nikt nie dawał gwarancji, że będą robiły to w sposób sprawiedliwy, etyczny czy zgodny z prawem.

Pojawiały się błędy modeli, problemy z jakością danych, a w niektórych branżach – jak medycyna

czy finanse – nawet ryzyko dla bezpieczeństwa użytkowników.

ISO/IEC 42001 powstała, aby te obszary uporządkować. Standard stawia przede wszystkim na przejrzystość, odpowiedzialność, zarządzanie ryzykiem oraz bezpieczeństwo danych w systemach sztucznej inteligencji.

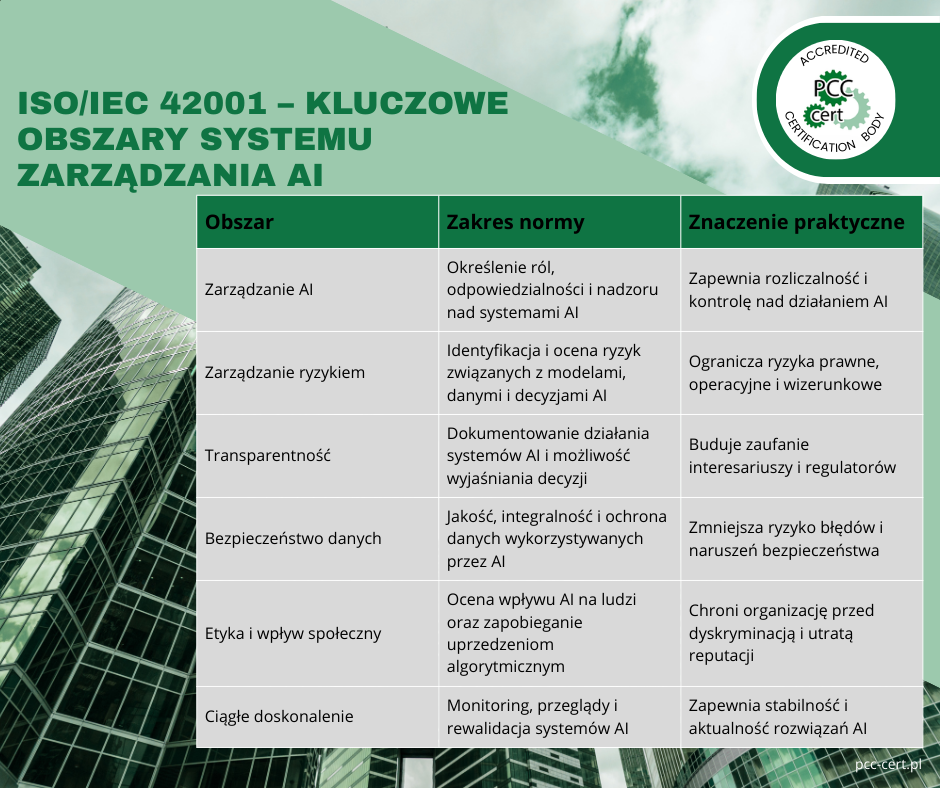

Co właściwie reguluje norma ISO/IEC 42001?

ISO/IEC 42001 jest normą zarządczą, a nie techniczną — to ważna różnica.

Nie rozstrzyga, jak budować modele czy jakich algorytmów używać. Zajmuje się tym,

co dzieje się wokół AI: jak ją projektować, jakie procesy powinny ją

nadzorować, kto ponosi odpowiedzialność i w jaki sposób kontrolować jej wpływ na organizację.

1. Zarządzanie ryzykiem AI

Norma wymaga, aby organizacja miała mechanizmy do identyfikowania i kontrolowania

ryzyk związanych z działaniem modeli AI. Chodzi tu m.in. o:

- błędy predykcyjne i nieprawidłowe wyniki modeli,

- uprzedzenia algorytmiczne (bias) w danych i modelach,

- kwestie bezpieczeństwa informacji,

- zgodność z regulacjami i wymaganiami prawnymi.

Ten obszar jest dobrze opisany w analizach

AWS

dotyczących ryzyk w cyklu życia AI.

2. Transparentność i odpowiedzialność

Wiele modeli działa dziś w sposób „czarnej skrzynki”, co utrudnia zrozumienie,

jak podejmują decyzje. ISO/IEC 42001 wymaga, aby organizacja potrafiła

wyjaśnić sposób działania swoich systemów AI — zwłaszcza jeśli wpływają one

na ludzi lub na kluczowe decyzje biznesowe.

CertiGet

zwraca uwagę, że to właśnie przejrzystość i możliwość wyjaśnienia decyzji modeli

jest jednym z najtrudniejszych elementów zarządzania AI.

3. Bezpieczeństwo danych i stabilność działania

AI pracuje na danych, których wartość w niektórych branżach przewyższa wartość samego

oprogramowania. Norma stawia więc wymagania dotyczące:

- jakości i integralności danych,

- ich ochrony i kontroli dostępu,

- sposobów trenowania i testowania modeli,

- monitorowania i stabilności działania systemów AI.

Zagadnienia te są szerzej omawiane m.in. przez

ISMS.online.

4. Etyka i sprawiedliwość modeli

Systemy AI mogą powielać albo nawet wzmacniać uprzedzenia obecne w danych. Norma wymaga

regularnych ocen wpływu, aby zapobiec takim sytuacjom oraz minimalizować

ryzyko dyskryminacji określonych grup.

Ten wątek szeroko opisuje również

KPMG, pokazując

praktyczne przykłady testowania etycznego AI i włączania aspektów etycznych w

procesy zarządzania technologią.

Kto skorzysta najbardziej na wdrożeniu ISO/IEC 42001?

Norma została stworzona z myślą o bardzo szerokim zastosowaniu — zarówno w startupie AI,

jak i w globalnej korporacji czy instytucji publicznej. Jej elastyczność wynika z zastosowania

High-Level Structure (HLS), dzięki czemu można ją łatwo zintegrować

z takimi systemami jak ISO 9001 czy ISO/IEC 27001.

Na ISO/IEC 42001 szczególnie skorzystają organizacje, które:

- tworzą lub wdrażają systemy AI w swoich produktach i procesach,

- pracują na danych wrażliwych (zdrowie, finanse, edukacja, sektor publiczny),

- stosują automatyczne modele oceniające klientów lub użytkowników,

- muszą wykazać zgodność z przepisami — zwłaszcza w kontekście europejskiego AI Act,

- chcą budować przewagę konkurencyjną dzięki odpowiedzialnemu wykorzystaniu technologii AI.

NFLO podkreśla, że rosnące

wymagania prawne i społeczne dotyczące etyki AI sprawiają, iż norma może stać się wkrótce

standardem rynkowym, a nie jedynie „opcją” dla najbardziej świadomych organizacji.

Jak wygląda wdrożenie ISO/IEC 42001 w praktyce?

Choć sztuczna inteligencja kojarzy się z zaawansowaną technologią,

wdrożenie normy ISO/IEC 42001 wcale nie polega na przepisywaniu kodu

czy projektowaniu nowych modeli. To przede wszystkim

uporządkowanie procesów zarządzania AI.

W praktyce wdrożenie przebiega zwykle w kilku etapach:

1. Analiza stanu obecnego (GAP Analysis)

- Czy organizacja w ogóle ma kontrolę nad swoją AI?

- Czy wie, jakie modele działają, kto je utrzymuje i na jakich danych pracują?

2. Zaprojektowanie systemu AIMS

Tworzony jest Artificial Intelligence Management System (AIMS), czyli system

zarządzania AI. Powstają m.in.:

- polityki i procedury dotyczące AI,

- rejestry ryzyka,

- zasady testowania i walidacji modeli,

- plan monitoringu i reagowania na incydenty.

3. Wdrożenie i edukacja zespołów

Norma dotyka wielu działów — IT, compliance, prawników, analityków, kierownictwa.

Kluczowe jest przeszkolenie zespołów oraz jasne przypisanie odpowiedzialności

za poszczególne elementy systemu AIMS.

4. Monitoring i ciągłe doskonalenie

AI zmienia się szybko, dlatego systemy trzeba stale oceniać, a modele regularnie

rewalidować. ISO/IEC 42001 opiera się na cyklu

ciągłego doskonalenia (PDCA), znanym z innych norm ISO.

5. Audyt i certyfikacja

Po wdrożeniu organizacja może przejść formalny

proces certyfikacji ISO/IEC 42001, który opisuje m.in.

SGS na swojej stronie.

Niezależny audyt potwierdza, że system zarządzania AI spełnia wymagania normy.

Jakie realne korzyści daje norma ISO/IEC 42001?

- Zwiększa zaufanie klientów i partnerów

W świecie, w którym AI często budzi obawy, certyfikat formalizuje odpowiedzialność organizacji

i pokazuje, że nadzór nad modelami nie jest pozostawiony przypadkowi. - Minimalizuje ryzyka

Błędy modeli, złej jakości dane czy problemy etyczne mogą mieć poważne konsekwencje

finansowe, prawne i wizerunkowe. Systemowe podejście pomaga je identyfikować

i redukować. - Przygotowuje na regulacje

ISO/IEC 42001 bardzo dobrze wpisuje się w nadchodzące przepisy europejskie,

w tym AI Act, ułatwiając organizacjom wykazanie zgodności. - Ułatwia integrację z innymi systemami zarządzania

Dzięki wspólnej strukturze (HLS) norma łatwo łączy się z ISO 9001 czy ISO/IEC 27001.

DNV podkreśla, że integracja systemów AI z istniejącymi systemami zarządzania

daje efekt synergii, a nie dodatkowej biurokracji. - Buduje przewagę konkurencyjną

Firmy, które potrafią udowodnić, że nadzorują swoje modele AI, są postrzegane

jako bardziej dojrzałe i profesjonalne, co może przekładać się na

lepszą pozycję rynkową.

Podsumowanie

ISO/IEC 42001 to coś więcej niż kolejny standard. To pierwszy krok w stronę

uporządkowanego i odpowiedzialnego świata sztucznej inteligencji.

Norma klarownie pokazuje, że AI musi mieć swoich właścicieli, zasady działania

i mechanizmy nadzoru — tak jak każde inne narzędzie wykorzystywane w biznesie.

W miarę jak AI staje się coraz bardziej powszechna, organizacje, które uporządkują ją

jako system zarządzania, będą miały naturalną przewagę. Zarówno pod względem

bezpieczeństwa, zgodności z regulacjami, jak i reputacji na rynku.